Tudo o que você precisa saber sobre Apache Airflow

Autor: Iuri Zambotto e Paulo Shindi

Tudo o que você precisa saber sobre Apache Airflow

Introdução

O Apache Airflow é uma plataforma open-source que permite a criação, agendamento e monitoramento de fluxos de trabalho complexos. Com sua interface intuitiva e capacidade de integração com várias tecnologias, o Airflow se tornou uma escolha popular para empresas que buscam automação eficiente e escalável. Vamos explorar o que torna o Airflow tão especial e como você pode começar a utilizá-lo.

O que é Apache Airflow?

O Apache Airflow foi desenvolvido originalmente pela Airbnb para lidar com a automação de fluxos de trabalho. Ele permite a definição de tarefas e suas dependências usando o Python, o que facilita a criação de workflows complexos. As principais características do Airflow incluem:

- Escalabilidade: Pode ser utilizado em pequenas tarefas diárias ou em fluxos de trabalho complexos com milhares de tarefas.

- Flexibilidade: Suporta diversos operadores para integração com outras ferramentas e serviços.

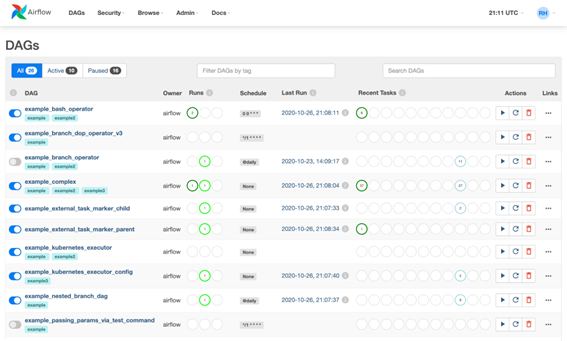

- Monitoramento: Interface gráfica robusta para monitoramento e gerenciamento de workflows.

Benefícios do Apache Airflow

Automação Eficiente

Com o Airflow, é possível automatizar tarefas repetitivas, reduzindo erros humanos e aumentando a eficiência operacional. Isso é crucial para empresas que lidam com grandes volumes de dados ou processos complexos.

Flexibilidade e Integração

A capacidade de integrar com várias tecnologias, como AWS, Google Cloud, e databases diversos, torna o Airflow uma ferramenta versátil. Ele pode ser configurado para atender às necessidades específicas de qualquer fluxo de trabalho.

Escalabilidade

Desde pequenas operações até grandes pipelines de dados, o Airflow se adapta às necessidades da sua organização, permitindo a escalabilidade conforme o crescimento da empresa.

Como Instalar o Apache Airflow Localmente

Requisitos

Antes de instalar o Airflow, certifique-se de ter o Python (versão 3.6 ou superior) instalado em seu sistema. Também é recomendado usar um ambiente virtual para evitar conflitos de dependências.

Passo a Passo de Instalação

- Criar um Ambiente Virtual:

python -m venv airflow_env source airflow_env/bin/activate

- Instalar o Apache Airflow:

pip install apache-airflow

- Inicializar o Banco de Dados do Airflow:

airflow db init

- Criar um Usuário Admin:

airflow users create \ --username admin \ --firstname <SeuNome> \ --lastname <SeuSobrenome> \ --role Admin \ --email <SeuEmail>

- Iniciar a Web Interface:

airflow webserver --port 8080

- Iniciar o Scheduler:

airflow scheduler

Acesso à Interface Web

Após iniciar o webserver, acesse http://localhost:8080 para visualizar a interface do Airflow, onde você pode gerenciar e monitorar seus fluxos de trabalho.

Opções de Implementação

A Airflow oferece várias opções de implementação para atender às necessidades e ao ambiente dos usuários:

1. Implementação Local: Execute a Airflow em uma máquina única usando o servidor web embutido.

2. Container Docker: Implemente a Airflow dentro de um container Docker para gerenciar instâncias Airflow fáceis e escaláveis.

3. Kubernetes: Utilize as habilidades de orquestração do Kubernetes para gerenciar múltiplas instâncias Airflow, garantindo alta disponibilidade e escalabilidade.

4. Serviços Cloud: Use serviços cloud como AWS, Google Cloud Platform (GCP) ou Microsoft Azure para implementar a Airflow em nuvem.

Componentes Principais do Airflow

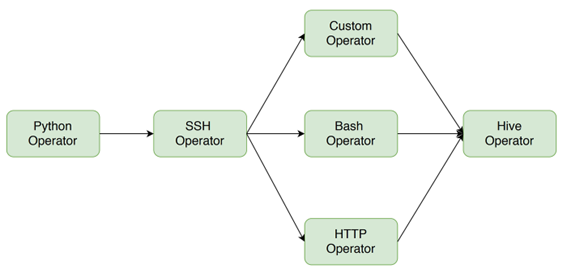

DAG (Directed Acyclic Graph)

Uma DAG é uma coleção de todas as tarefas que você deseja executar, organizadas de uma forma que reflete suas relações e dependências. No Airflow, DAGs são definidas usando Python, o que proporciona grande flexibilidade.

Operadores

Operadores são blocos de construção que definem o que cada tarefa deve fazer. O Airflow fornece uma ampla gama de operadores, incluindo:

- BashOperator: Executa comandos bash.

- PythonOperator: Executa funções Python.

- EmailOperator: Envia emails.

- MySqlOperator, PostgresOperator, etc.: Executa comandos SQL.

Sensores

Sensores são operadores especiais que esperam por uma determinada condição antes de prosseguir. Por exemplo, um sensor pode esperar por um arquivo em um bucket do S3 antes de iniciar o processamento.

Hooks

Hooks são interfaces para interagir com diferentes sistemas externos, como bancos de dados e APIs. Eles permitem a reutilização de conexões e autenticações, facilitando a integração com outros serviços.

Melhores Práticas para Usar o Airflow

Organize seus DAGs

Manter seus DAGs organizados em pastas e usar convenções de nomenclatura claras pode facilitar a manutenção e a legibilidade do seu código.

Use Variáveis e Conexões

Armazene configurações e credenciais sensíveis usando as variáveis e conexões do Airflow. Isso facilita a gestão e melhora a segurança.

Monitore e Logue Tudo

Utilize as funcionalidades de monitoramento e logging do Airflow para rastrear o desempenho dos seus fluxos de trabalho e identificar rapidamente quaisquer problemas.

Teste Localmente

Teste seus DAGs e operadores localmente antes de implantá-los em um ambiente de produção. Isso ajuda a identificar erros mais cedo e evita problemas maiores no futuro.

Documente seus Workflows

Adicione descrições e documentação aos seus DAGs e tarefas para facilitar o entendimento e a manutenção por outros membros da equipe.

Considerações Adicionais

Ao trabalhar com a Airflow, considere os seguintes:

1. Ingestão e Processamento de Dados: Desenhe workflows que eficientemente ingerem e processem grandes conjuntos de dados, levando em conta os requisitos de armazenamento e recuperação de dados.

2.Tratamento de Erros e Recuperação: Implemente mecanismos robustos para lidar com erros e garantir a recuperação suave de falhas ou sucesso parcial nos workflows.

3. Segurança e Autenticação: Segure a Airflow com mecanismos de autenticação e autorização para evitar acesso não autorizado e ataques de dados.

4. Escalabilidade e Desempenho: Escalar a Airflow horizontalmente adicionando mais trabalhadores ou nós, e otimizar o desempenho ajustando configurações de execução de tarefas e aproveitando processamento distribuído.

Conclusão

O Apache Airflow é uma ferramenta poderosa e flexível que pode transformar a maneira como sua empresa gerencia fluxos de trabalho. Desde a automação de tarefas simples até a coordenação de pipelines de dados complexos, o Airflow oferece uma solução escalável e eficiente. Seguindo as melhores práticas e aproveitando ao máximo suas funcionalidades, você pode otimizar significativamente seus processos operacionais.

Perguntas Frequentes (FAQs)

- O que é um DAG no Airflow? Um DAG (Directed Acyclic Graph) é uma estrutura que representa a sequência e as dependências de tarefas que devem ser executadas.

- Quais são os principais componentes do Airflow? Os principais componentes do Airflow incluem DAGs, Operadores, Sensores e Hooks.

- Posso usar o Airflow com outras ferramentas de nuvem? Sim, o Airflow integra-se facilmente com várias ferramentas de nuvem como AWS, Google Cloud, e Azure.

- Como posso monitorar meus fluxos de trabalho no Airflow? O Airflow oferece uma interface web robusta para monitoramento, além de funcionalidades de logging e alertas.

- O Airflow é adequado para pequenas empresas? Sim, o Airflow é escalável e pode ser configurado para atender tanto pequenas quanto grandes operações.

Espero que este guia tenha te ajudado a entender melhor o Apache Airflow e suas aplicações. Se você tiver alguma dúvida ou sugestão, não hesite em deixar um comentário!

Referências

Apache Airflow Documentation: https://airflow.apache.org/docs/apache-airflow/stable/

Airflow Tutorial: https://airflow.apache.org/docs/apache-airflow/stable/tutorial.html

Kubernetes Integration with Airflow: https://airflow.apache.org/docs/apache-airflow/stable/kubernetes.html

Gostou do artigo Tudo o que você precisa saber sobre Apache Airflow?